במסגרת קידום אתרים טכני, יש שלל פעולות שצריך לבצע כדי לשפר את ביצועי האתר. אחת מהן היא להשתמש בצורה נכונה בקובץ robots.txt – שמנחה את מנועי החיפוש בנוגע למה מותר ואסור להם לעשות.

מה זה קובץ רובוטס?

כשמו כן הוא, מדובר בקובץ טקסט פשוט המכיל הוראות והנחיות לרובוטים / זחלנים של מנועי חיפוש, שנקראים User Agents.

הקובץ נמצא בתיקייה הראשית של הדומיין, וכולל הנחיות עשה ואל תעשה בנושא זחילה ואינדוקס של עמודי האתר. בצורה כזו ניתן לשלוט בתקציב הזחילה באתר, ולא לבזבז אותו על עמודים חסרי תועלת (כגון עמוד רישום או כניסת login, עמוד עגלת קניות וכן הלאה).

כך נראה נתיב הקובץ באתר: website.com/robots.txt

קובץ robots.txt הוא למעשה חלק מסדרת כללים שלמה שנקראת REP – קיצור של Robots Exclusion Protocol. סדרת כללים זו כוללת גם את תגי Meta Robots שניתן להציב בעמודים ספציפיים באתר, זאת לעומת קובץ רובוטס שתקף לכל האתר כולו (וגם לכך יש סייגים כפי שנראה בהמשך). כמו כן גם מפות אתר הן חלק מפרוטוקול זה.

כאן המקום לציין שקובץ רובוטס הוא פורמט פקודות "חלש" יותר בהשוואה לתגית מטא רובוטס. הכללים בקובץ רובוטס לא אבסולוטיים, לעומת זאת הכללים במטא רובוטס כן אבסולוטיים. זו הסיבה שקובץ רובוטס אומנם יכול להגיד למנועי חיפוש לאן מותר ואסור להם להיכנס, אבל הוא לא יכול למנוע אינדוקס מוחלט של עמודים ותכנים.

אם העמוד חסום בקובץ רובוטס אבל מקור אחר מקשר אליו, סיכוי גדול שהוא יופיע במנועי חיפוש. רק תגית מטא רובוטס מסוגלת להסיר לחלוטין עמודים מתוך האינדקס, כאשר מוצבת בה פקודת noindex.

כללי הכתיבה בקובץ רובוטס

הסינטקס בקובץ robots פועל על בסיס כמה כללים פשוטים:

- Disallow – לא לאפשר פעולה מסוימת.

- Allow – כן לאפשר פעולה מסוימת.

- User-agent – הזחלן / הבוט שאליו מכוונים את ההנחיה (הבוט של גוגל, של בינג וכן הלאה).

- סימן כוכבית * – מתייחס להכול / לכולם (כל מנועי החיפוש, כל עמודי האתר, כל התיקיות וכו').

- סימן סולמית # – מאפשר להכניס הערות למשתמש אנושי בלי להשפיע על מנועי חיפוש.

- סימן דולר $ – מתייחס אך ורק למה שנמצא אחרי הסימן.

- וכן סימנים נוספים.

כמו כן חשוב לזכור שהקובץ רגיש לאותיות קטנות או גדולות. אם נבקש לחסום תיקייה שנקראת Admin, זה לא יחסום גם תיקיות שנקראות admin במקביל. כדי לוודא חסימה במקרה הזה, נצטרך לתת שתי פקודות נפרדות בקובץ – אחת לכל גרסה. זו עוד סיבה טובה לוודא שכתובות ה-url באתר הן באותיות קטנות. בנוסף גם שם הקובץ עצמו חייב להיות באותיות קטנות בלבד.

דוגמאות שימוש בקובץ robots

כך נחסום את כל האתר לחלוטין, עבור כל מנועי החיפוש וכל סוגי הזחלנים והבוטים:

User-agent: *

Disallow: /

הלוכסן בסוף מייצג את כל מה שבא אחרי הדומיין, כלומר כל העמודים. אם נוריד רק את הלוכסן בסוף השורה השנייה, הפקודה תתהפך – ותאשר סריקה של כל האתר. הרגישות הגבוהה הזו לכל שינוי הכי קטן, מחייבת הבנה טובה בתחביר הקובץ לפני שמעלים אחד לאתר או משנים אחד קיים.

כך נחסום עמוד ספציפי לסריקה של מנוע חיפוש ספציפי:

User-agent: googlebot

Disallow: /login-page

כך נחסום תיקייה ספציפית וכל מה שנמצא בתוכה (הלוכסן השני משמעו כל מה שבא אחרי התיקייה, כולל התיקייה עצמה):

User-agent: *

Disallow: /admin/

בנוסף לכללים עצמם, יש חשיבות גם לסדר ההנחיות. כאשר יש מספר הנחיות disallow ו-allow תחת אותו יוזר אייג'נט – כולן מתייחסות אך ורק ליוזר הזה (גם אם הוא מתייחס לכל מנועי החיפוש באמצעות כוכבית).

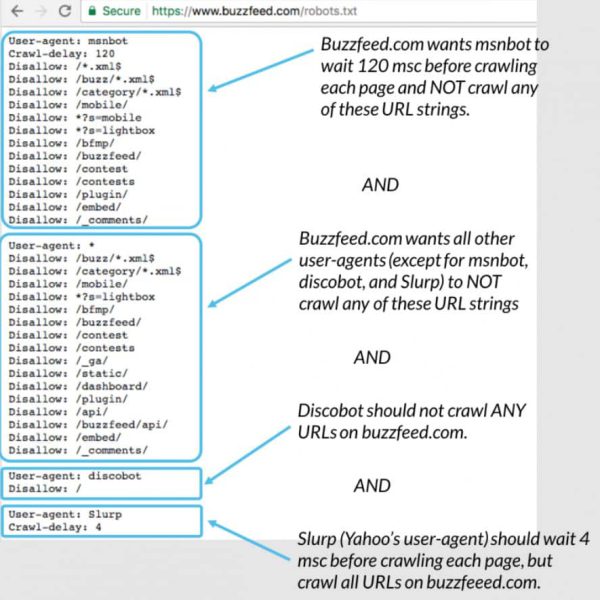

אם יש כמה יוזר אייג'נטס בקובץ, יש להפריד ביניהם בשורת רווח. הנה דוגמה לסט הנחיות (מתוך אתר Moz):

ניתן לראות שכל "קבוצת הנחיות" מופרדת ברווח, וכל אחת מהן מתייחסת ליוזר אייג'נט ספציפי (בינגבוט, דיסקובוט וסלרפ ששייך ליאהו). רק הקבוצה השנייה במספר מתייחסת לכל היוזר אייג'נטס באשר הם.

איך יוצרים ועורכים קובץ robots באתר?

ראשית יש לזכור שקובצי רובוטס גלויים גם למנועי חיפוש וגם לבני אדם, כל עוד הם נמצאים בתיקייה הראשית של הדומיין (כפי שצוין קודם לכן).

שנית, בדרך כלל באתרי וורדפרס יש קובץ רובוטס שנוצר אוטומטית בתצורת ברירת מחדל. כדי ליצור קובץ רובוטס מאפס או לערוך אחד קיים, מומלץ להשתמש בתוספים ייעודיים כגון יוסט או Rankmath. אפשרות נוספת היא עריכה ישירות באמצעות FTP או סי-פאנל בשרת האחסון של האתר.

איך בודקים מה חסום ומה לא?

- אפשרות אחת היא לבדוק את הקובץ בעצמכם, בהתאם לכללים שלמדנו כאן. בצורה כזו תוכלו לראות מה חסום בצורה רוחבית עבור כל האתר (למשל, כל מה שנכלל בתיקייה wp-admin באתר וורדפרס).

- אפשרות נוספת, מצומצמת יותר, היא לבדוק כתובת URL ספציפית בקונסולת גוגל. אם הכתובת חסומה בקובץ רובוטס (או מכל סיבה אחרת למעשה), אתם תקבלו על כך התראה לאחר הבדיקה.

- עוד אופציה שקיימת בקונסולת גוגל, היא בדיקה ישירה באמצעות כלי ייעודי בגרסה הישנה שעדיין קיימת. מתישהו היא כנראה תימחק לחלוטין – אבל כל עוד היא שם, אפשר לנצל זאת לבדיקה. בוחרים את האתר לבדיקה, ואז מקבלים גם את תצוגת קובץ רובוטס וגם חלונית למטה שמאפשרת לבדוק נקודתית איזה נתיב חסום או לא.

מה ההבדל בין קובץ robots.txt מול meta robots או x-robots?

כפי שכבר צוין בהתחלה, מדובר בסט כללים עבור בוטים – שמיועד לשימוש באתרי אינטרנט. הבדל אחד בין הסוגים השונים הוא שרובוטס טקסט הוא קובץ אמיתי שיושב באתר, ואילו השניים האחרים הם תגיות מטא שיושבות בקוד.

מעבר לכך, לכל אחד תפקידים שונים. קובץ רובוטס מכתיב התנהלות זחילה באתר כולו, בעוד שתגיות המטא ואקס רובוטס מכתיבות התנהלות עבור עמודים ספציפיים. לדוגמה: חסימת עמוד מלאה, כולל חסימת הקישורים בעמוד, תיראה כך בתגית מטא רובוטס:

<meta name="robots" content="noindex, nofollow">

רגע לפני סיום

קובץ robots.txt הוא רכיב רגיש מאוד בכל אתר. אם אינכם יודעים כיצד להתעסק בו ומהם הכללים וחוקי הכתיבה, מוטב לא לגעת בקובץ. בטעות אתם עלולים לחסום לעצמכם חלקים שלמים מהאתר, שלא ייסרקו יותר על ידי מנועי חיפוש.

מצד שני, מי שמבין מספיק יכול לעשות הרבה דברים עם הקובץ הזה. למשל, אם אנו רוצים למנוע מ-ahrefs או semrush לעקוב אחרי האתר שלנו (ולהציג את הביטויים והקישורים שלנו), אפשר לחסום את הבוטים שלהם באמצעות קובץ רובוטס:

User-agent: AhrefsBot

Disallow: /

User-agent: SemrushBot

Disallow: /

אותו דבר אפשר לעשות גם באמצעות תגית מטא רובוטס:

<meta name="AhrefsBot" content="noindex" />

<meta name="SemrushBot" content="noindex" />

חובה לזכור – אם חסמתם באמצעות התגית, אין צורך לחסום שוב באמצעות קובץ רובוטס. אחרת אתם עלולים ליצור התנגשות שתבטל את הכוונה המקורית.

עד כמה הפוסט הזה עזר לכם?

דירוג ממוצע 5 / 5. כמות דירוגים: 3

אף אחד עדיין לא דירג את הפוסט, אתם יכולים להיות הראשונים 🙂

אנחנו מצטערים לשמוע שהפוסט לא עזר לכם

נשמח לשפר את הפוסט

ספרו לנו איך נוכל לשפר אותו